2. 南京工程学院 基础部, 南京 211167

2. Department of Mathematics and Physics, Nanjing Institute of Technology, Nanjing 211167, China

进入新经济时代, 我国市场主体数量持续快速增长, 商标注册便利化改革带动商标申请量快速提升. 2017年3月底, 全国共有各类市场主体8 935.7万户. 2017年第一季度, 全国新登记市场主体359.8万户, 同比增长19.5%;商标申请量83.7万件, 同比增长13.9%.数据显示如何高效地管理海量的商标数据成为一个迫切问题, 因此, 针对巨大的商标库, 研究有效的商标图像检索技术十分重要.

用以"分类号"为关键词的商标检索模式, 图像的相似性主要靠人工识别, 存在工作量大、效率低的问题[1].商标图像检索(Trademark Image Retrieval, TIR)是对商标图像之间的重复性、相似性进行审查[2].国内外许多学者研究者提出了大量的商标图像检索技术和方法[1-6].宋瑞霞等[2]提出了边界特征和区域特征相结合的商标检索算法.张玲等[3]提出了一种极坐标下的分块检索方法.通过对商标图像进行归一化处理, 以目标对象的最小外接圆作为目标区域; 在极坐标下将图像分块, 计算形状直方图; 最后采用新的相似性度量方法计算图像间距离, 实现商标图像的准确检索. Tursun O等[4]提出了具有基准查询的大规模数据集可以系统地评估TIR方法. Yan Y等[5]针对彩色标识/商标图像检索, 提出了颜色空间描述子的自适应融合方法.它将颜色量化和k均值相结合, 以实现有效的主色提取.对于每个提取的主色, 将为局部特征导出基于组件的空间描述符. Anuar F M等[6]提出一种创新的商标检索技术, 通过整合全球和本地描述符, 提高检索性能.孙兴华等[7]提出了一种于子图像特征组合的商标图像检索算法.首先对商标图像进行子图像抽取, 然后根据子图像单特征计算图像与目标图像的单特征距离, 最后基于多特征组合得到图像相似性度量.商标表现为图像, 其数据作为一类图像数据, 其基于图像内容的检索具有一般图像数据检索的特征, 核心是提取特征、高维计算问题等.以上的商标图像检索都是基于传统的图像处理技术对商标图像进行处理, 针对大规模商标数据的检索质量和性能有待验证.

哈希技术作为解决高维数据近似最近邻居查询的关键技术, 将高维数据转换为一个低维度的表示, 或者二进制位编码, 进而在低维空间或者海明空间近似计算最近邻[8].现有的哈希方法可分为数据独立方法和数据依赖方法[8].数据独立方法将高维数据随机投影到低维空间, 代表性的方法是局部位置敏感哈希LSH[9]方法; 数据依赖方法采用机器学习技术, 使用训练数据学习哈希函数使得二进制编码满足一定的标准和准则, 该方法成为计算机图像处理、计算机视觉等目前的研究热点[8], 可以进一步分为有监督[10]和无监督[11]的方法.

哈希学习的任务是学习哈希函数

目前, 深度学习在图像处理等方面表现出良好的效果, 基于深度学习的图像处理、计算机视觉等应用取得了极大的成功[12-14], 尤其是在图像特征表示能力具有很强的优势[15].

得益于深度学习技术对图像特征自动提取和表达能力, 基于深度学习技术的哈希学习[15-20]借鉴了深度学习和哈希学习技术, 其高效性在图像检索等高维数据计算领域应用广泛. Liu H等[16]提出了深度监督散列(DSH)方法学习, 用于保持海量图像相似的二进制码方案. Xia R等[17]提出基于深度神经网络的哈希方法.论文通过优化问题的求解方法, 设计缩减神经网络的训练时间, 并加入损失函数来提升性能. Zhang R等[19]提出使用的加权海明距离的计算时间复杂度较大, 可以更加精确地计算海明距离, 并提高计算效率. Guo J等[21]提出了一种结合卷积神经网络(CNN)和散列学习的方法, 通过引入一个新的损失层和一个新的哈希层, 所提出的方法可以学习哈希函数, 保留了语义信息, 同时满足哈希编码所需的独立性.

商标作为商品和厂家的重要标志, 是具有高声誉价值的独特视觉符号, 不仅代表着商家的名誉, 还象征着商品质量, 是用来传达制造商想要维护的质量、创新和标准的某种保证.因此, 通过提供防止侵权的解决方案来激发对商标保护的需求势在必行.本文提出一种基于卷积神经网络模型的深度哈希学习的商标检索技术HTR (Hash Learning based Trademark Image Retrieval, HTR), 用于商标的视觉相似性计算与检索.

本文第1部分介绍了深度哈希学习; 第2部分介绍了本文系统的实现; 第3部分对算法进行了测试; 最后第4部分对本文进行了总结.

1 哈希学习 1.1 数据无关哈希局部敏感哈希(Locality-sensitive Hashing, LSH)[9]是解决高维数据近似最近邻搜索高效方法, 该方法是一种数据独立方法.使用随机投影将相似数据映射成相似的二进制代码, 能够保持数据最大可能的相似性.其采用随机线性映射, 将高维度数据空间中的邻近数据映射至低维空间, 使得相邻数据点通过相同的映射或投影变换后, 数据点在新空间中仍然以较大的概率相邻, 而不相邻的数据点被映射后相邻的概率很小. LSH的基本原理如公式(1)所示, 它把两个高维向量的相似性计算转变为计算两个哈希值相等的概率.

| $ \Pr [h(x_i )=h(x_j )]=sim(x_i , x_j), $ | (1) |

其中,

数据无关方法为了确保结果的质量, 哈希存在编码长度要求, 需要较长的哈希码来提高准确度[8, 23].

1.2 深度哈希学习基于哈希学习是一种数据相关的哈希技术, 基本原理是把高维数据映射到低维海明空间(Hamming Space), 使得相似对象的位编码(Bit Code)也相似, 通过在海明空间高效计算海明距离获得近似结果, 并提升查询计算效率[8].

给定包含

哈希学习的基本问题是:给定包含

| $ b_i ={\rm sgn}(F(x_i , \Theta )), $ | (2) |

其中sgn

为了使得每个编码后的二元码保持原始空间数据之间的关系, 谱哈希[11]提出了两个标准: ①相似性保持; ②位编码平衡准则.其中相似性保持确保原始空间的数据之间的距离关系, 能够通过海明编码保持和计算.编码平衡准则要求二元编码均匀分布, 并且各个bit位之间相互独立.基于哈希学习的查询要求满足: ①原始特征值与学习之后的数据之间的损失最小; ②二进制码均匀分布在每个比特位, 并且保证每一位的独立性.

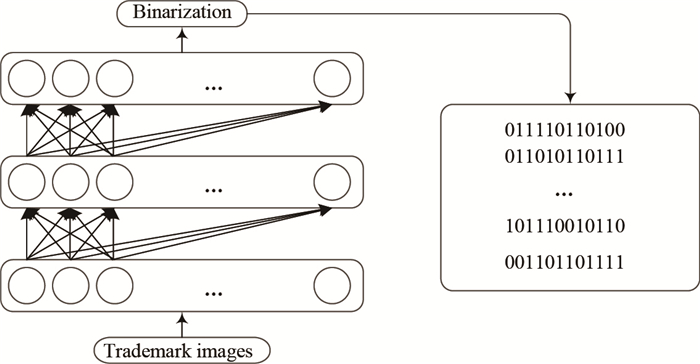

鉴于深度学习技术对图像特征自动提取和表达能力, 基于深度学习技术的哈希学习[16-17, 20]借鉴了深度学习和哈希学习技术, 不仅具有强大的特征学习能力, 而且具有较高的查询效率, 因此在图像检索等高维数据计算领域获得了广泛应用.图 1是HTR哈希学习方法的基本过程.对给定数据集, 设计深度神经网络, 在网络输出层计算二进制编码, 网络参数根据顶层优化目标函数进行反向传播更新.在目标数据集上进行训练得到目标网络模型.该结构使用网络模型提取图像特征, 然后用传统的哈希算法计算图像的二进制编码, 进而在海明空间进行图像相似性计算.

|

图 1 HTR哈希学习基本过程 Fig.1 Illustration of hash processing with HTR |

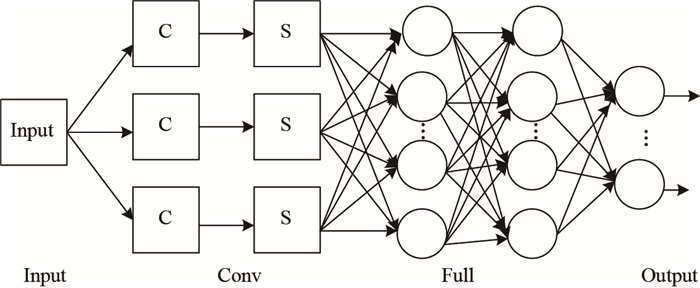

卷积神经网络(Convolutional Neural Network, CNN)[24-25]是深度学习中一种代表性结构, 是一种前馈式神经网络结果, 在语音识别、人脸识别和自然语言处理等方面取得了较好的应用效果.典型的卷积神经网络的基本架构如图 2所示, 通常由若干卷积层(Convolutional Layer)、激活层(Activation Layer)、池化层(Pooling Layer)及全连接层(Fully Connected Layer)组成.卷积神经网络的基本架构可分为4层:第1层为Input输入层, 第2层是Conv卷积层, 第3层是Full全连接层, 第4层是Output输出层.卷积神经网络是一种从输入到输出的非线性关系映射, 其有效地在输入与输出之间的建立非线性映射关系.卷积神经网络因具有位移、畸变鲁棒性和并行性等而受到广泛关注[25].

|

图 2 卷积神经网络的基本架构 Fig.2 Basic framework of convolutional neural network |

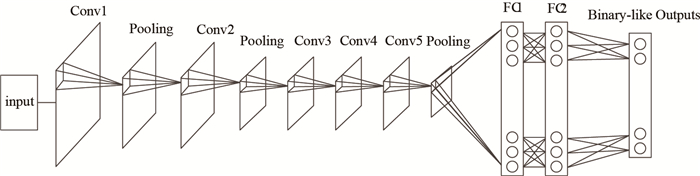

本文的深度网络采用CNN网络模型, 包括5个卷积层和2个全连接层.最后一层为Binary-like层.网络模型如图 3所示.

|

图 3 基于CNN网络的HTR哈希架构图 Fig.3 Hash learning framework of HTR based on CNN |

哈希架构图各层的设置和详细描述如下.

Conv1卷积层初始输入图像大小为3

Pooling1池化层不使用全0填充, 过滤器大小为1

| $ \begin{align} relu\left( x \right)=\max \left( {x, 0} \right)=\left\{ {{\begin{array}{*{20}c} {x, x\ge 0}, \hfill \\ {0, x<0}. \hfill \\ \end{array} }} \right. \end{align} $ | (3) |

Conv2卷积层使用过滤器为3

Pooling2池化层不使用全0填充, 过滤器大小1

Conv3卷积层使用过滤器为大小3

Conv4卷积层使用过滤器为大小3

Conv5卷积层使用过滤器为大小3

Pooling3池化层不使用全0填充, 过滤器大小1

全连接层FC1设节点数1 024个, FC2设节点数500个.

哈希层节点数为目标哈希码位数, 最终输出目标位数特征值.哈希编码的如公式(4).

2.3 HTR哈希设

| $ b_n =({\rm sgn}\left( {h_n^M -0.5} \right)+1)/2, $ | (4) |

| $ h_n^M =s\left( {W^Mh_n^{M-1} +c^M} \right). $ | (5) |

相似性度量方式, 海明距离就是在海明空间中, 两个特征向量对应位置二进制数不同的数量.不同的二进制数个数越多, 则海明距离越大, 向量之间的差异也就越大, 反之, 则越小.海明距离的计算如公式(6)所示,

| $ D\mbox{(x, y})=\sum\limits_{i=1}^n {x_i \oplus y_i } , $ | (6) |

其中,

商标图像查询HTR系统处理分为两步:离线哈希编码计算; 在线海明空间检索.通过在CNN中图像特征表示和分类输出层增加哈希层, 哈希层的二元编码的学习通过最小化定义在分类误差和其他性质上的目标函数来进行[27]. Liu H等[16]定义的损失函数如公式(7),

| $ L_R =wD_h +\left( {1-w} \right)\max \left( {m-D_h , 0} \right), $ | (7) |

其中,

| $ L_R =\sum\limits_{i=1}^N {\left\{ {w_i D_h +\left( {1-w_i } \right)\max \left( {m-D_h , 0} \right)} \right\}} +\alpha \left( {\sum\limits_{j=1}^N {\left| {\left| {H_i } \right|-1} \right|} } \right), $ | (8) |

其中,

HTR算法的过程见算法1.算法分为两步:离线哈希编码计算; 在线海明空间商标图像检索.离线阶段通过2.2节的CNN计算哈希码, 通过公式(8)的损失函数, 使得商标图像哈希之后的二元编码保持原始空间的相似性(行1—15).在线计算阶段, 对获得哈希编码建立索引, 在索引上计算查询

本文实验平台为Windows10系统, 16GB内存, QuadCore Intel Core i7-7700, 4.2 GHz.算法实现采用Python 3.5和Tensorflow1.8[28]实现.

3.2 数据集商标数据集采用FlickrLogos数据集[29], 该数据集描绘各种情况下的公司徽标, 由奥格斯堡大学多媒体和计算机视觉实验室维护, 应用于标识检索、多级标识检测和对象识别等算法中. FlickrLogos-32数据集中包含32类不同的商标种类, 32个商标种类分别为HP(112), ADIDAS(120), ALDI(106), APPLE(76), BECKS(100), CARLSBERG(108), BMW(74), CHIMAY(112), COCACOLA(130), CORONA(83), DHL(123), ERDINGER(105), ESSO(87), FEDEX(94), FERRARI(73), FORD(76), FOSTERS(98), GOOGLE(83), GUINESS(98), HEINEKEN(103), MILKA(197), NVIDIA(114), PAULANER(102), PEPSI(178), RITTERSPORT(204), SHELL(96), SINGHA(83), STARBUCKS(95), STELLAARTOIS(87), TEXACO(88), TSINGTAO(109), UPS(90).其中, 括号中的数字为数据集中该商标的个数.

商标数据集的预处理是根据商标图像中商标的位置信息, 首先对商标标志进行提取.对包含有多个商标都提取出来, 共提取标签图像3 404张.通过随机反转、随机亮度变换、随机对比度变换、图像的白化4种预处理以增加数据集数量.预处理后得到13 616张商标图像, 其中10 000张作为训练样本, 每个商标类别的测试个数为113, 共3 616张作为测试.图 4为数据集示例. 32个商标类别, 数据集标签采用从0—31进行编号, 图像进行预处理为32

|

图 4 FlickrLogos商标数据示例 Fig.4 Illustration of FlickrLogos dataset |

训练样本共10 000个, 图像大小为32

| 表 1 HTR默认参数设置 Tab.1 Algorithm for HTR |

系统的查询结果采用平均精度均值(Mean Average Precision, MAP), 计算公式如(9)所示.在多个类别的检测中, 取每个类对应AP值的平均值, 即为MAP.

| $ \mbox{MAP}=\frac{1}{\vert Q_R \vert }\sum\limits_{q\in Q_R } {\mbox{AP}(q)} , $ | (9) |

式中AP(Average Precision)是对于某一类商标

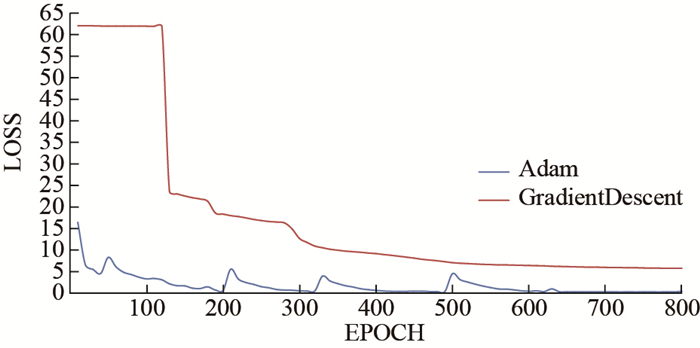

本文试验了两种优化器:梯度下降算法的优化器GradientDescent和自适应矩估计Adam优化器[30]进行训练.两种优化器的损失曲线如图 5所示. 图 5的横轴为迭代次数, 纵轴为损失函数损失值.从图 5可以得出结论:基于梯度下降法GradientDescent优化器在本数据集上收敛速度较慢, Adam优化器收敛速度更快, 损失值更小, 因此, 在本文的商标数据集上的CNN采用Adam优化器.

|

图 5 优化器的损失曲线对比 Fig.5 Loss curves comparison of different optimizers |

为损失函数添加正则项, 选择L1正则化与L2正则化方法.在哈希编码长度为32时, 测试的精确度对比如表 2.使用L2正则化的损失函数平均精确度较好, 但是训练时间较长.

| 表 2 HTR正则化方法 Tab.2 Default parameters for HTR |

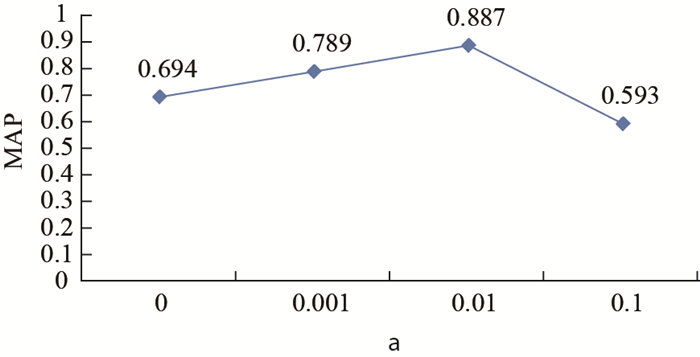

在公式(8)中的正则化L2下, 不同正则化参数

|

图 6 正则化参数 |

在生成哈希编码时, 设置不同的比特长度, 对模型效果影响不同.使用本文商标数据集进行训练测试, 分别在DSH[16]方法和HTR方法上测试12、32、64、128比特长度下的模型效果, 平均精确度如表 3所示.从表 3可以得出结论: ①本文方法在商标数据集的平均查询精确度好于DSH; ②哈希位长度为32时, 本文方法在商标数据集MAP值为0.874, 达到最好的查询精度.

| 表 3 查询质量对比 Tab.3 Regularization method for HTR |

HTR的在线查询性能如表 4所示.在默认参数设置下, 提交了3 616个查询, 表 4表明平均查询的时间开销在0.209 ms, 并且查询的性能与哈希Bit长度关系不大.结果表明在海明空间系统查询的效率较高, 并且比较稳定.

| 表 4 在线查询性能 Tab.4 Comparision of query results |

本文基于卷积神经网络和哈希学习技术实现了一个两阶段的商标图像检索系统.在CNN网络模型的基础上, 重点研究基于卷积神经网络哈希学习的损失函数, 哈希编码, 并实现了商标图像的高效在线检索.研究了通过卷积神经网络实现商标图像特征提取, 通过损失函数优化哈希编码.在哈希编码基础上, 实现在海明空间商标图像在线高效的检索, 提高查询效率.通过实验对比和分析, 证明了本文方法具有较好的查询性能.

| [1] | 黄元元, 刘宁钟. 利用特征点平均矩特征的商标图像检索[J]. 中国图象图形学报, 2010, 15(4): 637-644. |

| [2] | 宋瑞霞, 孙红磊, 王小春, 等. 边界特征和区域特征相结合的商标检索算法[J]. 软件学报, 2012, 23(2): 85-93. |

| [3] | 张玲, 邹北骥, 孙家广, 等. 一种基于极坐标下分块的商标图像检索新方法[J]. 小型微型计算机系统, 2007, 28(1): 66-69. DOI:10.3969/j.issn.1000-1220.2007.01.014 |

| [4] | TURSUN O, KALKAN S. METU dataset: A big dataset for benchmarking trademark retrieval[C]//14th IAPR International Conference on Machine Vision Applications. New York: IEEE, 2015: 514-517. |

| [5] | YAN Y, REN J, LI Y, et al. Adaptive fusion of color and spatial features for noise-robust retrieval of colored logo and trademark images[J]. Multidimensional Systems and Signal Processing, 2016, 27(4): 1-24. |

| [6] | ANUAR F M, SETCHI R, LAI Y K. Trademark image retrieval using an integrated shape descriptor[J]. Expert Systems with Applications, 2013, 40(1): 105-121. DOI:10.1016/j.eswa.2012.07.031 |

| [7] | 孙兴华, 郭丽. 基于子图像多特征组合的商标图像检索[J]. 模式识别与人工智能, 2002, 15(1): 14-20. DOI:10.3969/j.issn.1003-6059.2002.01.003 |

| [8] | WANG J, ZHANG T, SONG J, et al. A survey on learning to hash[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 769-790. DOI:10.1109/TPAMI.2017.2699960 |

| [9] | DATAR M, IMMORLICA N, INDYK P, et al. Locality-sensitive hashing scheme based on p-stable distributions[C]//Twentieth Symposium on Computational Geometry. New York: ACM, Symposium On Computational Geometry, 2004: 253-262. |

| [10] | STRECHA C, BRONSTEIN A M, BRONSTEIN M M, et al. LDAHash:Improved matching with smaller descriptors[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(1): 66-78. DOI:10.1109/TPAMI.2011.103 |

| [11] | WEISS Y, TORRALBA A, FERGUS R, et al. Spectral hashing[C]//Proceedings of the 22nd Annual Conference on Neural Information Processing Systems (NIPS). Vancouver: ACM.2008: 1753-1760. |

| [12] | WAN J, WANG D, HOI S C, et al. Deep learning for content-based image retrieval: A comprehensive study[C]//Acm Multimedia. New York: ACM, 2014: 157-166. |

| [13] | CRUZROA A, OVALLE J E, MADABHUSHI A, et al. A deep learning architecture for image representation, visual interpretability and automated basal-cell carcinoma cancer detection[C]//Medical Image Computing and Computer Assisted Intervention. Berlin: Springer Berlin Heidelberg. 2013: 403-410. |

| [14] | ZHU H, LONG M, WANG J, et al. Deep hashing network for efficient similarity retrieval[C]//National Conference on Artificial Intelligence. CA: AAAI, 2016: 2415-2421. |

| [15] | 彭天强, 粟芳. 基于深度卷积神经网络和二进制哈希学习的图像检索方法[J]. 电子与信息学报, 2016, 38(8): 2068-2075. |

| [16] | LIU H, WANG R, SHAN S, et al. Deep Supervised Hashing for Fast Image Retrieval[C]//IEEE Computer Society. IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2016: 2064-2072. |

| [17] | XIA R, PAN Y, LAI H, et al. Supervised hashing for image retrieval via image representation learning[C]//National Conference On Artificial Intelligence, CA: AAAI, 2014: 2156-2162. |

| [18] | 龚震霆, 陈光喜, 任夏荔, 等. 基于卷积神经网络和哈希编码的图像检索方法[J]. 智能系统学报, 2016, 11(3): 391-400. |

| [19] | ZHANG R, LIN L, ZHANG R, et al. Bit-scalable deep hashing with regularized similarity learning for image retrieval and person re-identification[J]. IEEE Transactions on Image Processing, 2015, 24(12): 4766-4779. DOI:10.1109/TIP.2015.2467315 |

| [20] | LIONG V E, LU J, WANG G, et al. Deep hashing for compact binary codes learning[C]//Computer Vision And Pattern Recognition. New York: IEEE, 2015: 2475-2483. |

| [21] | GUO J, ZHANG S, LI J, et al. Hash learning with convolutional neural networks for semantic based image retrieval[C]//Pacific-Asia Conference on Knowledge Discovery and Data Mining. Berlin: Springer, 2016: 227-238. |

| [22] | 向雷, 肖诗斌, 林春雨, 等. 基于轮廓与SIFT特征组合的商标图像检索[J]. 计算机工程与应用, 2013, 49(19): 167-172. DOI:10.3778/j.issn.1002-8331.1112-0552 |

| [23] | ANDONI A, INDYK P, NGUYEN H L, et al. Beyond locality-sensitive hashing[C]//Society for Industrial and Applied Mathematics. Proceedings of the twenty-fifth annual ACM-SIAM symposium on Discrete algorithms. New York: ACM, 2014: 1018-1028. |

| [24] | LI H, LIN Z, SHEN X, et al. A convolutional neural network cascade for face detection[C]//Computer Vision And Pattern Recognition. New York: IEEE, 2015: 5325-5334. |

| [25] | 周飞燕, 金林鹏, 董军. 卷积神经网络研究综述[J]. 计算机学报, 2017, 40(6): 1229-1251. |

| [26] | KRIZHEVSKY A, SUTSKEVER I, HINTON G E, et al. ImageNet Classification with Deep Convolutional Neural Networks[C]//Conference and Workshop on Neural Information Processing Systems. Cambridge: MIT Press, 2012: 1097-1105. |

| [27] | YANG H, LIN K, CHEN C, et al. Supervised learning of semantics-preserving hash via deep convolutional neural networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(2): 437-451. DOI:10.1109/TPAMI.2017.2666812 |

| [28] | GOOGLE. Tensorflow.[EB/OL]. (2015-04-10)[2018-04-20]. https://tensorflow.google.cn/get-started/. |

| [29] | CHRISTIAN E. Flickrlogos.[EB/OL]. (2011-05-15)[2018-04-10]. https://www.multimedia-computing.de/flickrlogos/data/. |

| [30] | KINGMA D P, BA J. Adam: A method for stochastic optimization[J/OL] CoRR, 2014, abs/1412. 6980: 1-15.[2018-05-20]. https://arxiv.org/pdf/1412.6980v2.pdf. |