2. 云南大学 民族学与社会学学院, 昆明 650500

2. School of Ethnology and Sociology, Yunnan University, Kunming 650500, China

近年来, 随着社会媒体在信息传播中发挥日益重要的作用, 社会媒体数据的抽取与分析也受到国内外学者的高度关注[1].从海量、异构的社会媒体数据中获取特定主题的数据, 并根据领域不同进行主题分析、内容筛选和过滤, 是社会媒体数据抽取的重要研究内容, 也是决策支持、影响预测、知识库构建和舆情分析等工作的重要基础[2].

与传统结构化数据不同, 社会媒体数据多为非结构化或半结构化, 具有规模大、短文本、多主题、数据稀疏和随意性强等特点, 为数据抽取与分析带来了挑战.具体包括: ①社会媒体数据非结构、多主题的特点, 需要一种扩展性强、支持多主题的方法进行主题特征抽取; ②特定领域的数据通常词源生僻、专业性强, 难以快速把握, 需要特定领域的先验知识作为基础, 利用领域知识丰富短文本信息量, 以提高针对特定领域数据抽取结果的准确性.

从对社会媒体数据处理和分析利用的方便性来看, 往往需要对数据大致内容按照主题识别和分类.目前主题分类方法有支持向量机(Support Vector Machine, SVM)[3]、人工神经网络(Artificial Neural Network, ANN)[4]和随机森林(Random Forests Algorithm, RFA)[5]等.然而, 由于SVM缺少对非线性问题的通用性, ANN学习过程较复杂, RFA在噪音较大时会产生过拟合结果, 因此, 在社会媒体数据的抽取问题上具有一定的局限性.

在研究文本集的隐含主题问题时, Blei等[6]提出了LDA(Latent Dirichlet Allocation)模型. LDA是一种经典贝叶斯层次模型, 其基本思想是将每个文本表示为主题的多项分布, 每个主题表示为词汇的多项分布, 进而得到文本潜在的主题结构. LDA模型被广泛用于信息抽取、文本分析、社交网络和自然语言处理等领域. Jaradat等[7]将LDA应用于Twitter数据主题分析; 文献[8]提出了非参数贝叶斯模型MB-HDP, 有效地实现主题分析; 文献[9]则使用LDA对海量的电影评论数据进行了定性和描述性的主题提取; 文献[10]在LDA的基础上根据情感层次扩展了在线模型, 实现更准确的微博主题和情感信息挖掘与分析; 文献[11]研究海量的电商评论数据, 实现了基于语义约束LDA的商品特征和情感词提取.但是, 针对特定领域的社会媒体数据抽取, 上述基于LDA的主题分析和信息挖掘方法仍有待进一步扩展.因此, 针对挑战(1), 本文基于LDA模型挖掘社会媒体数据中的隐含主题, 实现数据从"文本-词汇"到"文本-主题"的降维, 对于数据的多个主题, 获取各个主题的高频词, 对每条数据进行主题分析, 并得到数据的特征词序列, 实现对每条数据的特征抽取, 以简化数据的抽取问题.

知识图谱(Knowledge Graph, KG)是一种语义网络, 表达了实体、概念及其之间的语义关系, 广泛用于个性化推荐、智能搜索、知识发现、内容分发等领域. KG被用于医疗[12-13]、音乐[14]、建筑[15]等领域的信息抽取研究. Meij等[16]利用KG实现以文本为中心的信息检索.文献[17]研究关系抽取时提出一种面向中文维基百科领域知识的演化方法. Marin等[18]结合KG与无标签数据实现文本短语的分类. Kliegr等[19]将知识图谱应用于文本的信息分析中, 为海量数据中的信息分析和抽取提供了先验知识.文献[20]提出了一种将语义相似性聚类算法与KG结构相结合的KGRank方法, 以发现隐藏在文档中的语义关系, 实现关键词抽取的目的. KG同时有助于解决短文本数据稀疏的问题, 如Chen等[21]利用领域知识作为先验知识指导模型推理.针对挑战②特定领域的约束或知识, 本文首先将领域知识表示成KG, 然后利用KG丰富的实体信息获取特定领域的生僻词, 进而根据KG实体间的关联、同名实体的不同属性和异名实体可能指代同一事物的特征, 来判别一词多义、异词同义等情况.同时, 对于短文本数据稀疏、信息量少的特点, 我们利用KG的实体间的关联得到相似数据内容间的联系, 从而丰富短文本的信息、提高数据抽取的准确性.

本文第1节给出基于LDA的社会媒体数据主题分析; 第2节给出知识图谱引导下的数据抽取方法; 第3节给出实验结果; 第4节总结全文, 并展望将来的研究工作.

1 基于LDA的社会媒体数据主题分析本节中首先给出了社会媒体数据的表示, 再获取各个主题的高频词与数据特征词, 以此进行社会媒体数据的主题分析.为了便于阅读, 给出相关符号及其含义对照, 见表 1.

| 表 1 符号及含义 Tab.1 Notations |

我们用

定义1 社会媒体数据的一个实例

(1)

(2)

(3)

(4)

例1 表 2给出社会媒体数据的例子.

| 表 2 社会媒体数据示例 Tab.2 Examples of social media data |

数据由词汇组成, 词汇的集合存储在词典中, 定义如下.

定义2 词典用

词典

本文从"数据-词汇"中挖掘数据隐含的"主题"维度, 转化为低维的"数据-主题"问题. LDA用概率图模型表示[22], 如图 1所示.

|

图 1 LDA图模型 Fig.1 LDA graphic models |

其中,

(1)

(2)

公式(1)给出了第

| $ p(w_{i, j} |I_i )=\sum\limits_{k=1}^Kp(w_{i, j}|z_{i, j}=k)p(z_{i, j}=k). $ | (1) |

其中,

根据式(1)的结果来更新该词对应的主题, 如果更新后其主题发生变化, 反过来也会影响

本文用主题向量表示社会媒体数据, 用高频词向量描述各个主题.设

| $ \delta_{t, k}=\frac{n_k^{(t)}+\beta_t}{\sum\limits_{r=1}^Sn_k^{(r)}+S\beta_t }, $ | (2) |

| $ \lambda_{k, i}=\frac{n_i^{(k)}+\alpha_k}{\sum\limits_{r=1}^Kn_i^{(r)} +K\alpha_k }. $ | (3) |

其中,

每条数据

根据文献[23]的结论, 超参数

第1节通过特征抽取获得了数据特征词序列, 本节进一步实现特定领域数据的抽取.首先将领域知识表示为KG, 进而利用领域KG引导从社会媒体数据中抽取出特定领域的数据.

2.1 领域知识图谱的表示本节将领域知识表示为领域KG, 记为

定义3 用

领域知识由该领域学者研究总结得出, 用

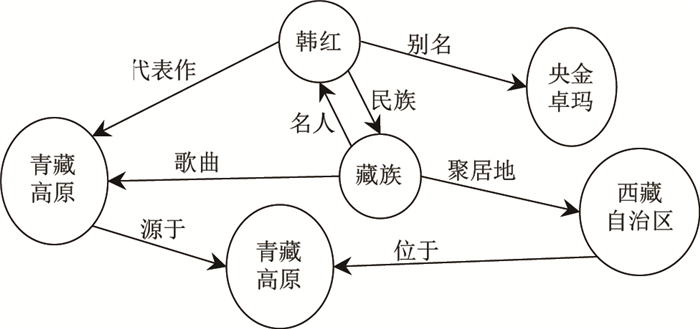

例2 图 2为领域KG的示例, 有向边表示节点间的关系, KG中节点名称相同不一定表示同一实体, 不同名的实体也可能表示同一对象.如两个"青藏高原"同名, 但表示不同属性的实体, 而"央金卓玛"与"韩红"表示同一人物.

|

图 2 领域KG示例 Fig.2 Example of field KG |

我们对特定领域之外的数据, 如旅游、广告、电商以及歧义词汇等影响数据抽取的知识也表示为知识图谱, 记为

我们将

| $ \begin{align} T=\left\{ \begin{array}{l}1, \quad (p>\tau)且(p'<\tau)\\ 0, \quad 其他\\ \end{array} \right.. \end{align} $ | (4) |

其中,

用

结合第1节主题分析获得的数据主题高频词向量和特征词序列, 最终抽取得到的领域数据表示为五元组(

例3 如表 3所示, 表中为一条以藏族领域为例的最终抽取的旅游主题的结果.

| 表 3 数据抽取结果示例 Tab.3 Example of data extraction results |

为了测试本文数据抽取方法的效率和有效性, 本文获取了今日头条平台[24] 2017年的21 567条数据, 以及新浪微博平台2017年某月中4 906 327条数据作为实验测试数据.数据包括

本文的实验以藏族领域为例测试领域数据的抽取方法, 首先, 将藏族领域知识表示为藏族KG, 用该藏族KG引导数据的抽取.由于实验的新浪微博数据的随意性, 无自带的分类标签, 为了得到准确可靠的测试数据, 我们对微博一周内906 327条数据做人工标记, 标记的标准为该条数据内容是否与本文测试的藏族领域相关.

利用已知分类和人工标记相结合, 实验测试了数据抽取方法的有效性, 以及算法1和算法2的效率.为了定量描述算法的有效性, 我们以准确率(Precision)、召回率(Recall)和

| $ F=\frac{2\cdot P\cdot R}{P+R}. $ | (5) |

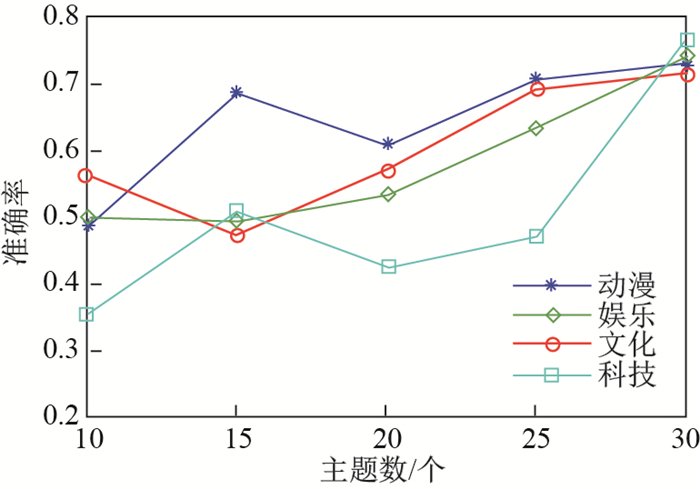

本文以"今日头条"新闻数据中的主题分类标签

|

图 3 主题分析准确率 Fig.3 Precision of topic analysis |

|

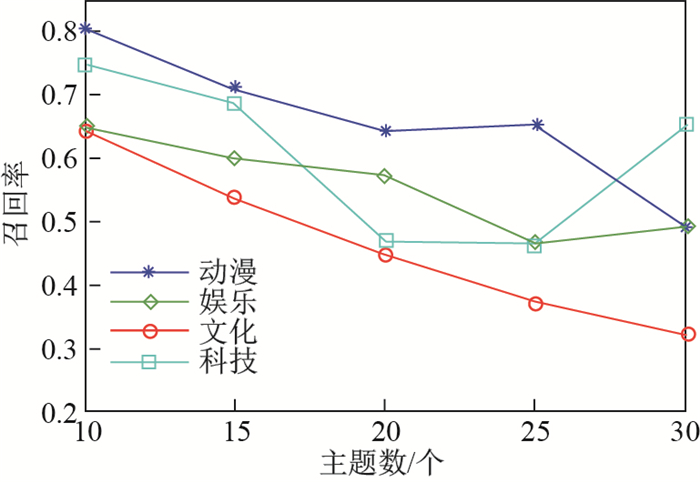

图 4 主题分析召回率 Fig.4 Recall of topic analysis |

|

图 5 主题分析 |

从图 3和图 4可以看出, 随着设置主题数的增加, 各个主题检测的召回率下降, 而准确率上升.即随着主题划分的细化, 每个主题下的数据进一步减少带来的变化, 对于如"科技"、"动漫"等区分性较强的主题, 其词汇与其他主题的词汇之间具有较为明显的区别, 设置主题数增多, 召回率依然较高.此外, 由于"娱乐"、"动漫"、"文化"和"科技"四个主题的数据分别占总数据的20.51%、7.85%、5.11%和3.35%, 不同主题的数据量也随着设置主题数的变化影响算法1的有效性.从图 5看出, 随着数据量的增加,

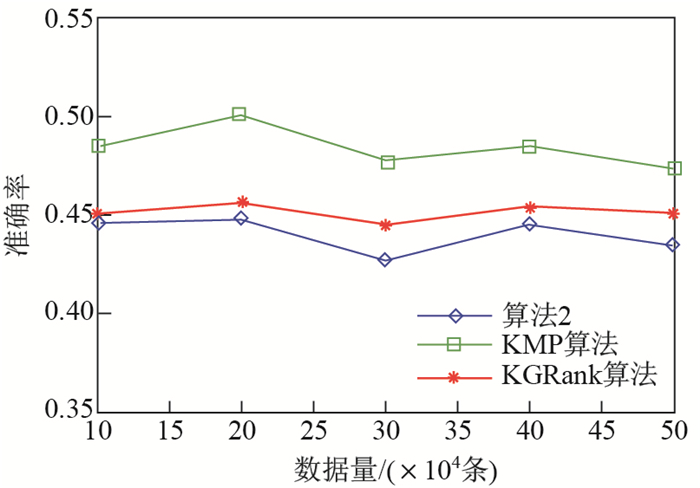

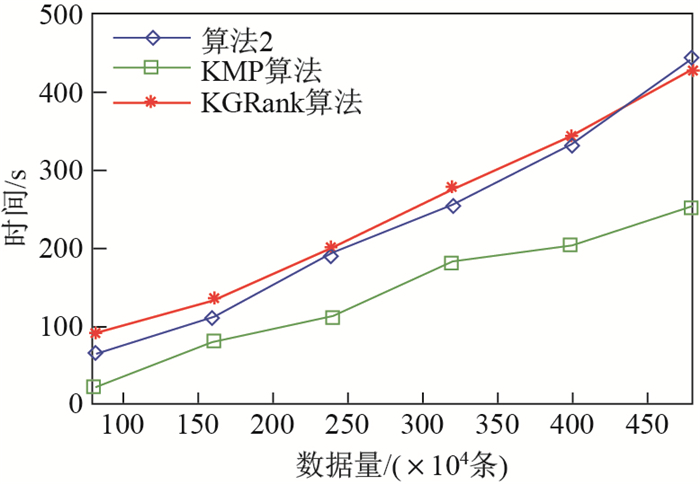

针对算法2特定领域的数据抽取, 本文以抽取藏族领域数据为例, 利用人工标记的906 327条微博数据进行测试, 并与KMP算法[25]为基础的关键词匹配筛选方法, 以及KGRank算法[20]为基础的数据抽取方法进行对比. KMP算法是一种高效的字符串匹配算法, 以KMP算法为基础的数据过滤方法是数据抽取的最基本形式.而KGRank是一种将语义相似性聚类算法与知识图谱结构相结合的关键词抽取方法, 以抽取的关键词为基础同样能实现数据的抽取.实验测试了三种方法的有效性, 结果分别如图 6、图 7和图 8.

|

图 6 数据抽取准确率 Fig.6 Precision of data extraction |

|

图 7 数据抽取召回率 Fig.7 Recall of data extraction |

|

图 8 数据抽取 |

由图 6、图 7和图 8可以看出, 本文抽取结果的准确性稳定在44%, 召回率在82%以上, 综合二者的

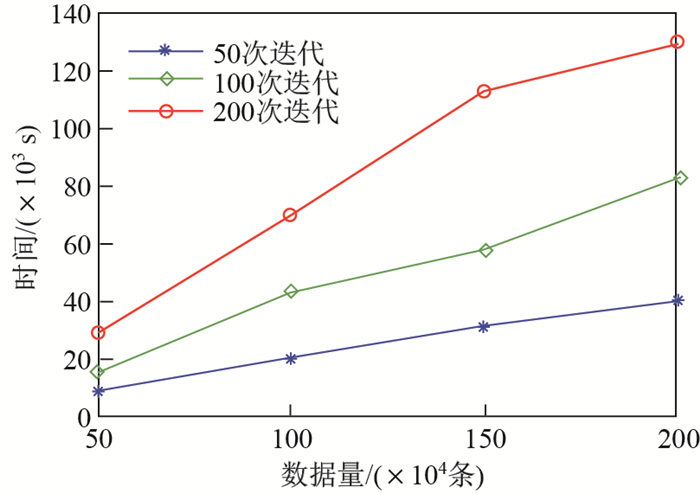

实验以新浪微博一个月的4 906 327条数据为依据, 对算法1、算法2的效率进行了测试.测试了算法1在不同迭代次数情形下, 随着数据量的增加执行时间的变化情况, 结果如图 9.实验还测试了算法2与KMP算法和KGRank算法为基础的数据抽取方法的效率对比, 结果如图 10所示.

|

图 9 算法1执行时间 Fig.9 Execution time of Algorithm 1 |

|

图 10 执行时间对比 Fig.10 Comparison of execution time |

由图 9可看出, 算法1的执行时间随着数据量增加而呈线性增长, 而随着迭代次数的增加, 执行时间呈现非线性增长.这是由于在一定的迭代次数内, 当结果已经达到收敛, 其后的迭代时间会减少.本文实验综合考虑算法效率与有效性, 设定100次迭代.由图 10可看出, 三个算法的执行时间都与数据量呈线性正相关, 算法2在相同条件下比KGRank算法省时, 而比KMP算法耗时.这是由于KMP算法的关键词匹配过程具有良好的性能, 其时间复杂度为

本文研究社会媒体数据的抽取, 给出了基于LDA模型的社会媒体数据主题分析方法, 该方法能够挖掘数据中隐含的主题, 实现特征抽取.进而引入领域KG, 提供了一种特定领域的数据抽取方法.但是, 实验数据来源还较为单一, 缺乏多平台、多维度的数据; LDA模型是非监督学习, 难以准确地、有目的性地进行主题划分; 且本文用领域知识表示KG, 领域知识的不完备性使得KG也不够全面.

我们接下来将进一步扩展数据来源, 获取包括网易新闻、Facebook、Twitter等多平台、多维度的数据, 针对更大规模的社会媒体数据对所提出的方法进行进一步测试.在特征抽取中实现监督或半监督学习, 提高准确性.而针对领域知识的不完备, 接下来将研究以数据驱动的领域KG增量化补全.针对海量数据规模的高效方法, 以及算法的进一步优化也是我们今后将要开展的工作.

| [1] | OUYANG Y, GUO B, ZHANG J, et al. SentiStory:Multi-grained sentiment analysis and event summarization with crowdsourced social media data[J]. Personal & Ubiquitous Computing, 2017, 21(1): 97-111. |

| [2] | HE W, WANG F K, AKULA V. Managing extracted knowledge from big social media data for business decision making[J]. Journal of Knowledge Management, 2017, 21(2): 275-294. DOI:10.1108/JKM-07-2015-0296 |

| [3] | ZHOU X, GUO L, LIU P, et al. Latent factor SVM for text categorization[C]//IEEE International Conference on Data Mining Workshop. IEEE, 2015: 105-110. |

| [4] | WAJEED M A, ADILAKSHMI T. Supervised and semi-supervised learning in text classification using enhanced KNN algorithm:A comparative study of supervised and semi-supervised classification in text categorization[J]. International Journal of Intelligent Systems Technologies & Applications, 2012, 11(3/4): 179-195. |

| [5] | RISTIN M, GUILLAUMIN M, GALL J, et al. Incremental learning of random forests for Large-Scale image classification[J]. IEEE Trans Pattern Anal Mach Intell, 2016, 38(3): 490-503. DOI:10.1109/TPAMI.2015.2459678 |

| [6] | BLEI D, NG A, JORDAN M. Latent dirichlet allocation[J]. Journal of Machine Learning Research, 2003(3): 993-1022. |

| [7] | JARADAT S, DOKOOHAKI N, MATSKIN M. OLLDA: A supervised and dynamic topic mining framework in twitter[C]//2015 IEEE 15th International Conference on Data Mining Workshop. IEEE, 2016: 1354-1359. |

| [8] | 刘少鹏, 印鉴, 欧阳佳, 等. 基于MB-HDP模型的微博主题挖掘[J]. 计算机学报, 2015, 38(7): 1408-1419. |

| [9] | DUPUY C, BACH F, DIOT C. Qualitative and descriptive topic extraction from movie reviews using LDA[C]//Machine Learning and Data Mining in Pattern Recognition. Springer, 2017: 91-106. |

| [10] | MA J, YAO Z, SUN M. WSO-LDA: An online "Sentiment+Topic" weibo topic mining algorithm[C/OL]//Pacific Asia Conference on Information Systems.[2018-07-01].http://aisel.aisnet.org/pacis2017/223. |

| [11] | 刘冰玉, 王翠荣, 王聪, 等. 基于动态主题模型融合多维数据的微博社区发现算法[J]. 软件学报, 2017, 28(2): 246-261. |

| [12] | KHOLGHI M, SITBON L, ZUCCON G, et al. External knowledge and query strategies in active learning: A study in clinical information extraction[C]//24th ACM International on Conference on Information and Knowledge Management. ACM, 2015: 143-152. |

| [13] | 陈德华, 殷苏娜, 乐嘉锦, 等. 一种面向临床领域时序知识图谱的链接预测模型[J]. 计算机研究与发展, 2017, 54(12): 2687-2697. DOI:10.7544/issn1000-1239.2017.20170640 |

| [14] | ORAMAS S, ESPINOSA-ANKE L, SORDO M, et al. Information extraction for knowledge base construction in the music domain[J]. Data & Knowledge Engineering, 2016, 106: 70-83. |

| [15] | VELASCO-ELÍZOÑDO P, MARIN-PINA R, VAZQUEZ-REYES S, et al. Knowledge representation and information extraction for analysing architectural patterns[J]. Science of Computer Programming, 2016, 121: 176-189. DOI:10.1016/j.scico.2015.12.007 |

| [16] | DIETZ L, KOTOV A, MEIJ E. Utilizing knowledge graphs in text-centric information retrieval[C]//Tenth ACM International Conference on Web Search and Data Mining. ACM, 2017: 815-816. |

| [17] | 高俊平, 张晖, 赵旭剑, 等. 面向维基百科的领域知识演化关系抽取[J]. 计算机学报, 2016, 39(10): 2088-2101. DOI:10.11897/SP.J.1016.2016.02088 |

| [18] | MARIN A, HOLENSTEIN R, SARIKAYA R, et al. Learning phrase patterns for text classification using a knowledge graph and unlabeled data[J]. ISCA-International Speech Communication Association, 2014(15): 253-257. |

| [19] | KLIEGR T, ZAMAZAL O. LHD 2.0:A text mining approach to typing entities in knowledge graphs[J]. Web Semantics Science Services & Agents on the World Wide Web, 2016, 39: 47-61. |

| [20] | SHI W, ZHENG W, YU J X, et al. Keyphrase extraction using knowledge graphs[J]. Data Science & Engineering, 2017, 2(4): 275-288. |

| [21] | CHEN Z, LIU B. Mining topics in documents: Standing on the shoulders of big data[C]//20th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. ACM, 2014: 1116-1125. |

| [22] | BLEI D. Probabilistic topic models[J]. Communications of the ACM, 2012, 55(4): 77-84. DOI:10.1145/2133806 |

| [23] | LU Y, MEI Q, ZHAI C. Investigating task performance of probabilistic topic models:An empirical study of PLSA and LDA[J]. Information Retrieval, 2011, 14(2): 178-203. DOI:10.1007/s10791-010-9141-9 |

| [24] | 北京字节跳动科技有限公司.今日头条媒体平台[EB/OL].[2017-12-31]. https://www.toutiao.com/. |

| [25] | KNUTH D E, MORRIS J H, PRATT V R, et al. Fast pattern matching in strings[J]. SIAM Journal on Computing, 1977, 6(2): 323-350. DOI:10.1137/0206024 |