目前企业问答系统常见的有基于检索式的、基于生成式的、混合式的这3种方法.给定一个问题, 基于检索的方法会从问答知识库中检索到最相似的问题并返回与之对应的答案; 基于生成的方法, 会通过训练的生成模型, 生成对应的答案; 而混合的方法, 会将基于检索式的、基于生成式的有效地结合起来. FAQ常问问题集, 通常由用户提出的历史问题标注得到.基于FAQ的问答是检索式问答的重要组成部分, 其返回的结果具有稳定、可靠、质量高的特点.这种技术方法得到了广泛应用, 如电商、打车、外卖等互联网服务业的客服系统, 银行、通信、医疗等传统行业的信息服务系统, 以及农作物病虫害防治、法律知识普及等经济社会的各个领域.

基于FAQ的问答首先需要人工构建高质量的知识库, 这通常由企业资深的客服人员通过挖掘客服日志标注, 或由各个行业的专家在整理大量的行业资料后得到.当接收到用户提出的问题时, 只需要从知识库中找到与之最相似的问题, 并将其对应的标准答案返回给用户即可.因此, 基于FAQ问答的技术关键是如何从数据集中找到与当前问题最为相似的问题, 也就是如何计算两个句子之间的语义相似度.目前主流的方法是采用深度学习技术.但是由于FAQ需要依赖于人工标注的知识库, 所以其数据规模通常比较小, 在这种情况下, 进行语义计算的深度神经网络会陷入过拟合或遭遇性能瓶颈.为了提升FAQ问答模型的效果, 减少FAQ数据集训练语料不足的问题, 本文提出了一种迁移学习方法, 主要贡献如下.

(1) 提出了一种面向迁移学习的语义相似度计算的深度神经网络transAT, 该模型可以适用于不同规模的数据集, 有效地处理FAQ问答任务.

(2) 利用社区问答数据作为源域数据集, FAQ数据集作为目标域数据集, 基于数据层面和模型层面设计并实现了可行的迁移学习方案, 减少了源域数据集中噪声的影响.

本文第1节阐述基于FAQ问答的国内外研究现状; 第2节定义FAQ问答的问题本质, 并且介绍迁移学习数据层面的方案; 第3节介绍迁移学习模型层面的深度语义网络模型—FAQ问答模型; 第4节通过与其他参照模型的实验对比, 证明本文提出的transAT模型和迁移学习方法的有效性; 第5节总结本文工作并展望未来工作.

1 国内外研究现状基于FAQ问答技术的关键是如何计算文本之间的相似度, 从该点出发可以将现有的工作分为3个阶段: ①基于传统信息检索的方法; ②基于机器学习的方法; ③基于深度学习的方法.下面具体加以说明.

信息检索领域的文本相似度计算以向量空间模型[1]为代表, 它首先把文本表示为向量空间中的向量, 通过向量间的距离表示文本相似度, 其中文本特征权重的计算包括TF-IDF(Term Frequency-Inverse Document Frequency)、BM(Best Matching)25[2], 以及TF-IDF基于Ngram的变种等模型.向量空间模型可以有效捕捉浅层的语义特征, 但是对于词序、句法结构、深度语义却无法有效表征.文献[3]应用集合中的词频去改善BM25中TF-IDF的值, 与其他方法相比, 这种方法有着更好的效果.

基于机器学习的方法是将文本相似度计算转变为分类问题、回归问题或者排序问题.人工定义的特征工程是传统机器学习方法的核心.除了TF-IDF值外, 还会深入挖掘文本的长度、词序的变化、句法描述等方面的特征.文献[4]通过定义词对齐特征、问题的文法特征, 应用learn-to-rank方法基于FAQ训练了一个排序模型.

基于深度学习的方法是当前业界的主流方法, 它在文本相似度计算领域取得了显著的成果.从预训练的词向量Word2vec[5]、Glove[6], 到深度语义特征提取器CNN(Convolutional Neural Networks)[7]、RNN(Recurrent Neural Network)[8]、LSTM(Long-Short Term Memory)[9]、Transformer[10], 再到迁移学习等理论在NLP(Natural Language Processing)领域的应用[11-13], 在大数据量的情况下, 深度学习已被证实超过信息检索、传统机器学习技术在NLP域的表现. PWIM[14](Pairwise Word Interaction Modeling)充分融合了LSTM、注意力机制和DCNN(Deep CNN)的特性, 在包括WikiQA等多个NLP任务上都显著提升了效果. BERT[12](Bidirectional Encoder Representations from Transformers)通过在大规模通用语料上预训练, 然后到具体的NLP任务中做微调, 就有超过11项NLP任务中的最佳效果.文献[13]中提出了一种混合模型框架, 可以学习到从源域数据空间到目标域数据空间共有的特征表示和语义关联, 通过迁移学习的方法提升FAQ任务的效果, 模型被应用到AliExpress在线系统, 线上效果得到了显著提升.文献[14]尝试不同的迁移学习任务, 发现NLI(Natural Language Inference)任务更适合迁移到其他NLP任务中.文献[15]中通过在答案提取阶段改进迁移学习方法从而提升了传统问答系统的效果.

通过分析以上工作, 本文发现深度学习面临的主要问题在于, 基于深度神经网络的方法缺乏足够规模的标注数据, 且相应的迁移学习方法需要有与目标域数据分布相似的一定规模的源域数据集.基于此, 本文提出了利用社区问答数据作为源域数据集, 运用迁移学习的方法提升FAQ问答模型的效果; 为降低噪声的影响, 分别在数据层面和模型层面做了相应的设计.

2 问题定义和数据层面设计 2.1 问题定义借鉴前人的工作, 本文将基于FAQ的问答任务转变为PI(Paraphrase Identification)任务[16], 即语义等价任务, 判断两个句子是否语义等价.

给定集合

| $ \begin{align*} \mathrm {arg}\max\limits_{\!\!\!\!\!\!\theta}=\left\{\sum\limits_{(S_i, T_i, y_i)\in Q}\log (p(y_i |S_i, T_i;\theta))\right\}, \end{align*} $ |

其中,

首先, 以目标域数据集作为种子, 从百度知道爬取相关的问答对, 然后进行语义等价问题挖掘工作.在此之前, 首先需要定义语义等价问题的标准.在问答系统中, 答案需要满足用户的信息需求, 而问题反映了用户的查询意图.因此, 本文采用以下标准:如果两个问题可以被相同的答案回答, 那么认为这两个问题是语义等价的[17].在具体量化时, 首先考虑答案的相似性.但因为答案来源于网络社区, 可能质量不高, 所以, 会在计算时加上查询相似性.整个计算过程可以定义为, 给定问答对集合

| $ \mathrm {sim}(q_i, q_j ) =\alpha R(q_i, q_j )+(1-\alpha)R(a_i, a_j) , $ | (1) |

| $ R(q_i, q_j ) =\gamma \mathrm {BM}25(q_i, q_j )+(1-\gamma)\mathrm {cos}\langle W(q_i ), W(q_j)\rangle , $ | (2) |

其中,

| $ \begin{align} W(q_i )=\sum\limits_{k=1}^n h_k^{(i)}, \end{align} $ | (3) |

其中,

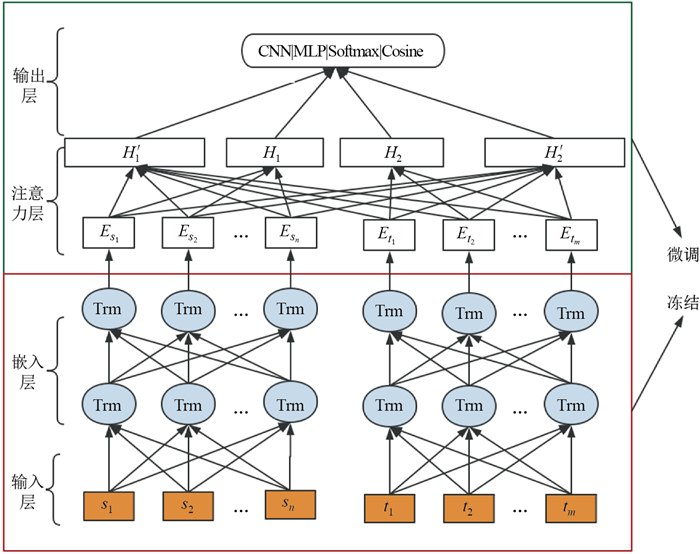

在第2.1节中, 本文将基于FAQ的问答任务转变为NLP领域中的句子分类任务.因此, 语义计算网络的输入是一个句子对, 输出则是两个句子文本是否语义等价的标签.借鉴前人的网络设计理念, 以及BERT的设计思想, 本文提出了一种新的神经网络结构transAT. transAT整个网络被分为4层, 分别是输入层、嵌入层、注意力层、输出层, 具体如图 1所示.

|

图 1 语义计算神经网络结构 Fig.1 Structure of a semantic computing neural network |

输入层主要负责文本的编码工作, 输入的内容包括文本信息和位置信息这两部分, 这是由嵌入层采用的Transformer神经网络结构决定的.在嵌入层, Transformer分别对文本信息和位置信息做嵌入和编码的操作, 然后经过Transformer编码器获得句子的深度语义特征.经过嵌入层后, 每个词被映射到语义空间中长度为

| $ \begin{align} H_1=\sum\limits_{i=1}^nE_{s_i}. \end{align} $ | (4) |

| $ {\mathrm e}_{s_i} =E_{s_i}\cdot H_2, $ | (5) |

| $ \alpha_{s_i} =\frac{{\mathrm e}_{s_i}}{\sum\limits_{j=1}^n {\mathrm e}_{s_j} }, $ | (6) |

| $ H_2' =\sum\limits_{i=1}^n\alpha_{s_i} {\mathrm e}_{s_i}, $ | (7) |

同理可得

| $ y^p =\mathrm {mean}(\cos \langle H_1', H_2'\rangle + \cos\langle H_1, H_2\rangle), $ | (8) |

| $ {\mathrm {Loss}} =\frac{1}{k}\cdot\sum\limits_{i=1}^k(y_i-y_i^p)^2. $ | (9) |

针对"预训练+微调"这种迁移学习方式, 常用的迁移学习策略有局部微调和全局微调这两种策略.本文分别应用这两种迁移学习策略, 针对transAT神经网络设计了相应的迁移学习方案, 并在实验中加以了对比.

3.2.1 局部微调通常随着神经网络层数的递增, 所捕获到的特征也将更抽象、更高级.底层的神经网络所学习到的通常是低级特征, 而底层特征的复用性相比高级特征来说是更强的.因此, 在局部微调时, 往往会复用整个神经网络模型底层的参数, 而对顶层的参数进行微调.在微调时, 通常的做法是, 对网络层的模型参数做继续训练, 使模型参数可以自适应目标域数据集的特点.另一种做法是, 对模型参数重新初始化进行训练, 这种方式可以有效屏蔽来自源域数据集噪声的影响, 加快模型的收敛速度.

针对本文的transAT神经网络模型, 冻结Transformer层及以下部分的模型参数, 对其以上部分做微调操作, 如图 2所示.尝试不同的微调方法, 对比实验结果, 最后确定最优的迁移学习方式.

|

图 2 transAT神经网络局部微调方案 Fig.2 Local fine-tuning scheme of a transAT neural network |

与局部微调相比, 全局微调会在微调时, 修改整个神经网络的全部参数, 使得神经网络可以更好地适应目标域数据集.考虑到输出层对训练模型的影响, 本文针对transAT神经网络模型设计了3种全局微调的迁移学习方案: ① transAT模型在预训练和迁移学习时, 拥有相同的神经网络结构, 在微调时, 对所有参数做更新操作; ② transAT模型在预训练时, 输出层采用全连接层, 损失函数采用二分类交叉熵, 在微调时, 输出层变为余弦距离, 损失函数为MSE; ③同方案②相反, 预训练时采用"余弦距离+MSE", 微调时采用全连接层.

4 实验结果 4.1 实验设置本文设计了两部分实验:一部分是语义等价任务实验, 因为在前文提到, 受限于标注数据形式, 将FAQ问答任务转变为NLP中的PI任务, 即语义等价任务; 另一部分是FAQ问答任务实验, 模拟线上流程, 测试模型在离线数据上的效果.经过前期数据预处理, 通过爬取社区问答数据, 获得有效语义等价问题对404 354个, 这部分作为源域数据集; 人工标注的FAQ的数据集包含有效问题对43 556个, 这部分作为目标域数据集.对源域数据和目标域数据进行比对发现, 虽然在数据处理阶段, 通过设置查询种子和挖掘语义等价问题等方式, 保证了源域数据和目标域数据在内容上的相关性和形式上的一致性, 但实际结果是, 它们之间仍然存在一些差异.从两个数据集随机抽取5个标准问和扩展问, 得到的结果如表 1所示.

| 表 1 源域和目标域数据对比 Tab. 1 Comparison of data from the resource and target domain |

通过对比发现, 源域和目标域数据在表达方式、用词规范, 以及涉及的领域都有一定的差别.因此, 源域数据中是存在一些噪音的.比如表 1中,

"小米note2耗电快怎么办"与"与荣耀6的网络位置怎么耗电这么快"两个问题存在语义差距, 但是因为源域数据来自网络社区, 必然会存在差异, 所以本文在微调时尝试了不同的策略, 以弱化这种影响.本文所有实验的平台为Linux GPU服务器, 其中, CPU为Intel(R) Xeon(R) CPU E5-2650 v4 @ 2.20 GHz

在语义等价任务实验中, 首先需要构造负例, 此处采用随机构造负例法构造负例.分别对源域数据集和目标域数据构造负例, 并且以8:2划分训练集和测试集, 得到的结果如表 2所示.

| 表 2 语义等价任务实验数据集划分结果 Tab. 2 Semantic equivalent experimental data partitioning results |

在语义等价任务实验中, 选取LSTM、BCNN、PWIM模型作为参照模型, 其中, LSTM模型采用基础的架构, 即Word Embedding+LSTM+全连接层实现, BCNN和PWIM分别应用Github上的开源项目实现.

在FAQ问答任务中, 源域数据集划分与语义等价任务实验一致, 目标域数据集重新划分训练集和测试集, 保证问题对中的每个标准问题均匀地分配到训练集和测试集中, 得到训练集39 074个问题对, 测试集4 075个问题对.然后, 针对训练集尝试用不同的负例构造方法和负例占比构造负例; 对于负例构造方法, 分别尝试用BM25构造负例和随机法构造负例.对于负例占比, 分别生成负例占比为1:1, 1:2, 1:3, 1:5的训练集.为了模拟场景, 在测试时, 首先用基于Ngram的TF-IDF模型做召回操作, 召回前50个候选项, 加快了实验效率, 避免了过多干扰项的影响.

4.2 实验结果首先, 分别对源域数据集和目标域数据集进行语义等价任务实验, 各个模型在不同数据集上的结果如表 3、表 4所示.表 3、表 4中, Precision为精确率, Recall为査全率, F1表示F1-score, Time cost为模型从训练到收敛的时间.

| 表 3 各个模型在源域数据集的测试结果 Tab. 3 Test results for various models in the source domain datasets |

| 表 4 各个模型在目标域数据集的测试结果 Tab. 4 Test results for various models in the target domain datasets |

从表 3可以看出, 本文提出的transAT模型在源域大规模数据集上, 超过了所有的参照模型, 达到了很好的结果, 并且在训练时间上远小于神经网络架构复杂的PWIM模型.由此证明transAT模型在大规模语料上, 有着很强的学习能力, 并且在性能上, 有着更短的训练时间和更快的收敛速度(Time cost).

从表 4可以看出, transAT模型在目标域数据集上也超过了参照模型, 并且取得了很好结果, 有效避免了过拟合的发生.

因为参照模型没有相应的迁移学习方案, 此处, 只针对transAT模型对比不同的迁移学习方案, 设计以下5组迁移学习方案: ①采用局部微调的方式, 微调时重新初始化参数再训练, 记为fine_tune0; ②采用局部微调的方式, 微调时接着原有的参数继续训练, 记为fine_tune1; ③采用全局微调方式, 不改变网络结构, 记为fine_tune_all; ④采用全局微调方式, 预训练时输出层用余弦距离+MSE, 微调时输出层为全连接, 记为CSBC; ⑤采用全局微调方式, 预训练时采用全连接, 微调时采用余弦距离+MSE, 记为BCCS.不同的迁移学习方式, 在目标域数据集上的测试结果如表 5所示.

| 表 5 不同迁移学习方式的迁移学习效果 Tab. 5 Results of various transfer learning methods |

从表 5可以看出, 局部微调的效果很差.分析其原因是, 当把Transformer层的参数冻结后, 可以调节的参数量很小, 模型会很快地收敛, 受源域数据集影响太大; 而全局微调的结果会好很多, 并且BCCS方式, 超过了未经过迁移学习训练的transAT模型效果, 这证明了迁移学习方式的有效性.

在FAQ问答任务实验中, 首先测试不同负例构造方式对模型结果的影响.本文用精确率(Precison)来衡量效果, Precison@1(P@1)代表返回结果top 1的精确率, 这和实际的问答场景一致, 因为真实的问答系统只返回一个正确答案.各个模型结果如表 6所示.从表 6可以看出, 基于BM25模型构造负例的方法要优于随机(random)构造负例的方法, 究其原因, BM25构造的负例更具有区分性, 可以帮助模型学习到不常见的特征, 提升模型的区分能力.并且, 在FAQ问答任务实验中, 经过迁移学习训练的transAT模型(transAT (pretrain))要优于其他所有参照模型.

| 表 6 不同负例构造方式, FAQ问答实验结果 Tab. 6 Results of FAQ QA experiment with different negative sample constructions |

然后测试不同负例占比对模型结果的影响, 实验结果如表 7所示.从表 7可以看出, 在训练时, 不同的负例占比对结果的影响很大.整体来看, 随着负例占比数量的增加, 模型的区分能力越来越强, 但是当负例占比过高时, 也会对模型的效果产生负面的影响.本文提出的transAT模型相比于参照模型, 效果有显著的提升, 并且经过迁移学习的transAT (transAT(pretrain))取得了更优的效果.

| 表 7 不同正负例占比, FAQ问答实验结果 Tab. 7 Results of FAQ QA experiment with different ratios of positive and negative |

在实验过程中, 本文对神经网络的结构设计、模型的超参数、注意力层的影响等方面做了大量的实验分析, 碍于篇幅限制, 此处只介绍语义等价任务实验中注意力层的影响.

在语义等价任务实验中, 为了直观感受注意力层对实验结果的影响, 本文分别做了对比实验, 并且对注意力层的输出结果进行了可视化操作.通过实验发现, 在transAT网络中加入注意力层与不加入注意力层的差距非常显著, 不加入注意力层在源域数据集上得到的F1为0.972 4, 小于最优结果0.983 1, 在目标域数据集上得到F1为0.939 8远小于最优结果0.962 2.注意力层的可视化结果如图 3所示.

|

图 3 注意力机制权重图 Fig.3 Visualization of attention weights |

从图 3可以看出, 发热与散热这两个词存在明显的语义间隔, 并且在图上有清晰的显式, 说明transAT中应用的注意力网络可以有效地学习词之间的语义关联, 帮助网络学到更好的语义特征.

5 总结与展望本文针对FAQ问答数据集规模有限、训练语料不足的问题, 提出了应用社区问答数据集作为源域数据集进行迁移学习训练.为了有效屏蔽社区问答数据集中噪声的影响, 分别在数据层面和模型层面设计了相应的解决方法.在数据层面, 通过爬取策略和语义等价问题挖掘, 保证了源域数据集和目标域数据集数据的一致性和相关性; 在模型层面, 提出了一种面向迁移学习的深度神经网络结构transAT和不同的迁移学习策略.实验证实, transAT网络可以有效适应不同规模的数据集, 并且优于PWIM、BCNN等参照模型, 取得了很好的效果.通过实验证明, 基于本文提出的设计方案, 可以有效提升FAQ问答任务中模型的效果, 有效缓解数据集规模有限对模型造成的影响.

迁移学习被广泛地应用到NLP领域中, 并且取得了很好的效果.在接下来的工作中, 需要进一步尝试不同的迁移学习方法, 进一步提升模型的效果.

| [1] |

TURNEY P D, PANTEL P. From frequency to meaning:Vector space models of semantics[J]. Journal of Artificial Intelligence Research, 2010, 37: 141-188. DOI:10.1613/jair.2934 |

| [2] |

ROBERTSON S, ZARAGOZA H. The probabilistic relevance framework:BM25 and beyond[J]. Foundations and Trends in Information Retrieval, 2009, 3(4): 333-389. |

| [3] |

KATO S, TOGASHI R, MAEDA H, et al. LSTM vs BM25 for open-domain QA: A hands-on comparison of effectiveness and efficiency[C]//Proceedings of the 40th International ACM SIGIR Conference on Research and Development. ACM, 2017: 1309-1312.

|

| [4] |

WANG Z G, ITTYCHERIAH A.FAQ-based question answering via word alignment[J]. arXiv: 1507.02628v1[cs.CL].

|

| [5] |

MIKOLOV T, SUTSKEVER I, CHEN K, et al. Distributed representations of words and phrases and their compositionality[C]//Proceedings of the 2013 Conference on Neural Information Processing Systems Association. NIPS, 2013: 3111-311.

|

| [6] |

PENNINGTON J, SOCHER R, MANNING C D. Glove: Global vectors for word representation[C]//Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing Association for Computational Linguistics. EMNLP, 2014: 1532-1543.

|

| [7] |

KIM Y. Convolutional neural networks for sentence classification[C]//Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP). ACL, 2014: 1746-1751.

|

| [8] |

LIPTON Z C. A critical review of recurrent neural networks for sequence learning[J]. arXiv: 1506.00019v1[cs.LG].

|

| [9] |

SAK H, SENIOR A W, BEAUFAYS F. Long short term memory recurrent neural network architectures for large scale acoustic modeling[C]//Proceedings of the 2014 Conference of the International Speech Communication Association. INTERSPEECH, 2014: 338-342.

|

| [10] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]//Advances in Neural Information Processing Systems 30(NIPS 2017). 2017: 6000-6010.

|

| [11] |

DEVLIN J, CHANG M W, LEE K, et al. BERT: Pretraining of deep bidirectional transformers for language understanding[C]//Proceedings of the 2015 Conference of the North American Chapter of the Association for Computational Linguistics Human Language Technologies. 2019: 4171-4186.

|

| [12] |

YU J F, QIU M H, JIANG J, et al. Modelling domain relationships for transfer learning on retrieval-based question answering systems in e-commerce[C]//Proceedings of the 11th ACM International Conference on Web Search and Data Mining. 2018: 682-690.

|

| [13] |

NIE Y X, BANSAL M.Shortcut-stacked sentence encoders for multi-domain inference[C]//Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing Association for Computational Linguistics, EMNLP 2017, 2017: 41-45.

|

| [14] |

CONNEAU A, KIELA D, SCHWENK H, et al. Supervised learning of universal sentence representations from natural language inference data[C]//Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. ACL, 2017: 670-680.

|

| [15] |

KRATZWALD B, FEUERRIEGEL S. Putting question-answering systems into practice: Transfer learning for efficient domain customization[J]. ACM Transactions on Management Information Systems, 2019, 9(4): 15: 1-15: 20(Article No.15).

|

| [16] |

HE H, LIN J J. Pairwise word interaction modeling with deep neural networks for semantic similarity measurement[C]//Proceedings of the 2015 Conference of the North American Chapter of the Association for Computational Linguistics Human Language Technologies. 2016: 937-948.

|

| [17] |

CHEN Q, ZHU XD, LING Z H, et al. Enhanced LSTM for natural language inference[C]//Proceedings of the 2017 Annual Meeting of the Association for Computation Linguistics. ACL, 2017: 1657-1668.

|