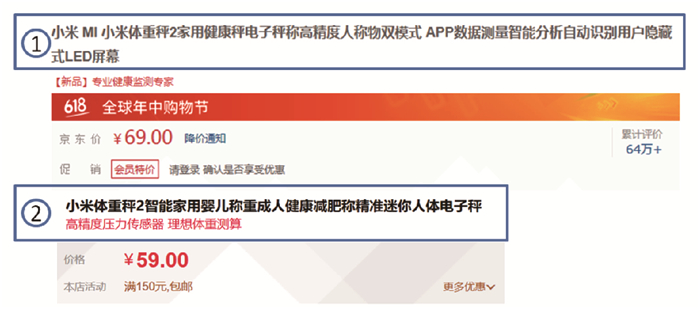

在真实的购物体验中, 消费者通常仅使用几个关键词对商品进行检索; 对于商品知识本身来说, 即可以使用更加精简的商品关键词汇对商品进行知识表示.为了让商品尽可能地被搜索引擎检索到, 商品提供商通常使用丰富的商品描述词汇组成商品标题, 虽然这种商品名称存在信息冗余, 但得益于电脑端良好的可视化环境, 长文本商品标题依然可以很好地向用户提供商品信息.然而, 对于不同的电商平台, 受限于商品平台知识体系的不同, 同一商品在不同的商品平台的描述体系中存在不一致性.这种差异不利于进一步构建跨平台商品知识对齐、多源商品的数据融合.因此, 有必要消除商品名称中的冗余词汇, 这项工作被称为冗长商品名称精简. 图 1展示了同一商品在不同电商平台下的显示情况, 标号①为商品在京东1平台显示情况, 标号②为在天猫2平台显示情况.

|

图 1 商品在两种不同平台下的显示情况 Fig.1 A sample product display on different e-commerce platforms |

商品名称精简归属于短文本信息提取工作, 然而不同于短文本信息提取, 商品名称表现出以下特点: ①商品名称长度相对稳定, 维持在一定长度以内; ②商品标题内部语义依赖关系薄弱; ③商品名称词性单一, 通常由名词及少量的形容词构成.目前已提出的短文本关键信息提取可以归纳为基于词频共现关系的方法和基于强语义依赖关系的方法这两种.在处理商品名称精简时这两种方法表现出以下不足: ①基于词频共现关系的方法所提取的目标特征单一, 需要构建全局关联矩阵来计算其属性特征, 在处理大规模数据时存在时间上和空间上的计算开销过大; ②基于强语义依赖关系的方法并不适用于商品名称精简, 因为真实的商品名称往往并不具备基本的语法依赖关系, 甚至仅仅由一些简单的名词拼凑而成, 无法通过其依赖关系进行进一步分析.

针对商品名称的特点以及现有方法的不足, 本文提出了基于自注意力机制[1]的冗长商品名称精简方法, 主要贡献如下.

(1) 首先提出了一种端到端的基于自注意力机制的冗长商品名称精简方法, 命名为ERS-NET, 该方法具有简洁高效的特点, 并且不需要依赖外部数据.

(2) 根据商品名称精简的特点, 提出了使用基于门控循环单元的神经网络来解决自注意力机制无法直接采集商品时序信息的问题, 并以此取代了自注意机制网络中的三元前馈网络, 以较小的代价换取了模型整体性能的提升.

(3) 在LESD4EC数据集[2]的基础上, 生成了商品名称精简数据集LESD4EC_L和LESD4EC_S, 并以此为基础进行了冗余商品名称精简的验证.实验结果表明, 本文提出的ERS-NET网络模型优于已提出的商品名称精简的基准模型.

1 相关工作对于冗长商品名称精简, 主要基于自然语言处理中的文本摘要生成及关键词提取任务的研究.研究者们希望在原始文档中生成包含文档关键内容的摘要, 减少信息观察者的信息观测量, 提升文档信息检索效率[3].传统的提取式方法主要依赖于对文本特征的选择. Rose等人提出了基于词频共现特征的文本关键词生成方法RAKE (Rapid Automatic Keyword Extraction)算法[4]. Mihalcea等人提出使用图结构重新组织文本特征, 利用PageRank算法来提取摘要信息, 并命名为TextRank[5]. Zhao等在TextRank方法的基础上, 考虑文本的主题及上下文信息特征, 提出了TopicPhraseRank模型[6], 用于Twitter文本的摘要信息归纳.无论是基于图结构特征还是词频特征的方法, 在构建全局关系矩阵时都面临着计算空间开销过大的问题, 所以此类方法并不能很好地应对大规模文本信息的摘要生成任务.随着神经网络技术在自然语言处理领域不断取得的显著成就, 研究者们根据短文本摘要任务的特性, 采用合适结构的网络进行文本摘要生成任务的研究工作, 此类方法通常采用带有长短期记忆网络[7](Long Short-Term Memory, LSTM)或门控循环单元[8](Gated Recurrent Units, GRU)的神经网络模型, 配合注意力机制[9-10], 不需要过多的特征选择, 直接通过学习文本的词嵌入特征进行摘要生成. Nallapati等提出了使用基于Seq2Seq(Sequence to Sequence)模型[11]的神经网络进行文本摘要生成, 将其命名为TextSum模型[12]; 文献[13]在此基础上, 精简了该模型的网络结构, 提出了基于概率预测的SummaRuNNer网络模型来预测文本摘要信息. See等对基于Seq2Seq的摘要生成模型进行了改进[14], 引入指针(Pointer Networks)机制[15]进行文本摘要的生成.冗长商品名称精简均是基于以上工作进一步展开的.

现有的研究工作主要分为抽象式方法和提取式方法.抽象式方法不局限于原文本中的词汇, 通过获取原文本中的语义特征, 从词汇表中生成语义连贯的摘要. Zhang等提出了基于GAN(Generative Adversarial Networks)网络[16]思想的MM-GAN模型[17], 对商品标题的信息进行压缩, 该方法使用Seq2Seq模型作为GAN的生成器, 抽象生成商品短标题, 并使用另外一个基于LSTM的RNN(Recurrent Neural Networks)对生成的信息质量进行判别.提取式方法是从原文本中提取目标词汇, 重新组合成文本摘要. Wang等提出使用查询日志对商品信息进行外部语义增强[18], 进一步对商品标题做短标题生成. Gong等在现有工作的基础上使用外部词频特征(Term Frequency-Inverse Document Frequency, TF-IDF)以及命名实体特征(Named Entity Recognition, NER)来对商品信息进行特征增强[2], 提出了基于LSTM的神经网络模型-FE-NET模型, 以此来处理商品短标题生成, 并提供了基于淘宝网站1的商品短标题数据集LESD4EC.本文工作在提取式商品短标题生成的基础上, 弱化问题本身对外部特征数据的依赖, 进一步对商品名称精简技术展开研究.

2 基于自注意力的商品名称精简方法 2.1 问题定义本文将冗余商品名称精简转化为序列二分类问题.给定商品名称序列

| $\begin{equation} S=T\cap Y, \quad y_{i}\in \{0, 1\}\wedge \vert S\vert \le \gamma, \end{equation} $ | (1) |

其中,

冗长商品名称精简的目标在于给定名称序列

| $\begin{equation} \label{eq2} L=\min \sum\nolimits_i^n {\varphi \left( {P({y}'_i \vert t_i , \mathrm {e}_i ), P (y_i \vert t_i , {\mathrm e}_i )} \right)} , \end{equation} $ | (2) |

其中

相对于RNN和CNN(Convolutional Neural Networks)网络, 自注意力机制网络具有良好的并行性, 并且可以捕捉句子全局依赖关系[1], 不足之处在于浅层自注意力机制网络无法快速获取文本的时序关系.已提出的自注意力机制网络使用一个前馈神经网络, 将输入的文本信息映射成为三元关系矩阵, 查询矩阵

| $\begin{equation} \label{eq3} \mathrm {ATT}=\mathrm {Softmax}\left(\frac{QK^{\rm T}}{\sqrt {d_k } }\right )V \end{equation} $ | (3) |

计算缩放点积注意力ATT得分.

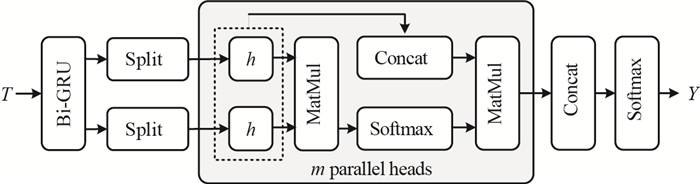

本文采用基于自注意力机制的网络来解决冗长商品名称精简, 所提出的网络模型整体架构如图 2所示.

|

图 2 基于自注意力机制的冗长名称精简模型 Fig.2 Overview of the ERS-NET model |

首先通过一个词嵌入网络层, 将输入商品名称序列

| $\begin{equation} \label{eq4} \overrightarrow h =\overrightarrow {\mathrm {GRU}} \left( {T'} \right), \end{equation} $ | (4) |

| $\begin{equation} \label{eq5} \overleftarrow h =\overleftarrow {\mathrm {GRU}} \left( {T'} \right). \end{equation} $ | (5) |

运用GRU网络的时序捕捉能力, 在得到双向GRU网络的隐层输出表示

| $\begin{align} \label{eq6} \mathrm {dot}& =\left( {\frac{\overrightarrow h \times \overleftarrow h ^\mathrm{T}}{\sqrt {d_h } }} \right) , \end{align} $ | (6) |

| $\begin{align} \label{eq7} \mathrm{ATT} &=\frac{\mathrm{exp}\left( {\mathrm{dot}_i } \right)}{\sum\nolimits_i^n {\mathrm{exp}\left( {\mathrm{dot}_i } \right)} }\cdot \left[ {\overrightarrow {h_i } :\overleftarrow {h_i } } \right] . \end{align} $ | (7) |

本文采用Vaswani等提出的多头并行方案[1], 将所得到GRU隐层输出结果通过

| $\begin{equation} \label{eq8} \mathrm{Head}_i =\mathrm{ATT}\left( {\overrightarrow h W_i^Q , \overleftarrow h W_i^K } \right), \end{equation} $ | (8) |

其中,

利用上述过程得到的多头矩阵拼接成为一个完整的矩阵, 通过全连接网络层实现目标矩阵的一个线性映射, 并使用Softmax分类器进行商品词标记预测, 最后使用最小交叉熵对其预测结果进行损失计算, 所对应的公式分别为

| $\begin{align} \label{eq9} H&=[\mathrm{Head}_i :\cdots :\mathrm{Head}_h ]W^o+b^o, \end{align} $ | (9) |

| $\begin{align} Y&=\mathrm{Softmax}\left( {[H:E]} \right) , \end{align} $ | (10) |

其中,

| 算法1 ERS-NET商品名称精简算法 |

| 输入:训练集商品名称 |

| 输出:测试集精简商品短标题 |

| 1: train: |

| 2: for all网络参数do |

| 3: 使用截断正态分布随机初始化参数 |

| 4: |

| 5: /*读取数据*/ |

| 6: |

| 7: for st |

| 8: |

| 9: |

| 10: |

| 11: for |

| 12: 使用公式(6)计算商品词语义关系 |

| 13: 使用公式(8)计算单头注意力得分 |

| 14: |

| 15: |

| 16: |

| 17: |

| 18: |

| 19: model.save() |

| 20: min |

| 21: 使用Adam方法最小化交叉熵损失函数 |

| 22: end for |

| 23: test: |

| 24: model.load() |

| 25: Y_predict |

| 26: S←Y_predict |

2.3 算法复杂度分析

在冗长商品名称精简中, 本文使用计算复杂度为

在实验过程中, 本文分别随机从LESD4EC_L和LESD4EC_S数据集中抽取500 000条商品数据作为训练数据, 50 000条作为测试数据.商品名称被映射到300维度的向量空间中进行词嵌入操作, 并使用截断正太分布

本文所使用的原始数据集LESD4EC包含6 481 623条数据, 并提供了商品名称(title)、商品命名实体标注信息(NER)、商品摘要数据(

| 表 1 商品数据集合并样例析 Tab. 1 Example of product title datasets union |

| 算法2 商品名称精简数据集合并算法 |

| 输入:商品数据集LESD4EC, 关键词上限个数 |

| 输出:商品名称精简数据集LESD4EC_L, LESD4EC_S |

| 1: for title in LESD4EC |

| 2: repeat |

| 3: 将与title相同ID的商品标记 |

| 4: 更新至LESD4EC_L; |

| 5: until无可更新数据; |

| 6: 根据NER信息为title标记分配权重, 根据权重计算标记得分Score; |

| 7: 根据Score得分, 在title内部进行词汇排序, 并剔除Score为0的词汇; |

| 8: if有效标记词汇数 < |

| 9: 将有效标记词汇更新到LESD4EC_S; |

| 10: else |

| 11: 将前 |

| 12: end for |

3.2 实验基准模型

在对比实验中, 本文选取了编码-解码模型Seq2Seq[11]、自注意力机制模型Self_ATT以及基于多特征输入的FE_NET模型[2]作为基准测试模型. Seq2Seq是一种广泛应用于文本解析的深度学习模型. Self_ATT源于Transformer模型[1], 应用于机器翻译.为了适用于商品名称精简, 本文从原有的Transformer模型中提取了完整的自注意力机制网络结构, 并构造了自注意力网络Self_ATT模型. FE_NET模型是专门用于商品短标题生成的模型.

3.3 实验评估标准本文采用ROUGE(Recall-Oriented Understudy for Gisting Evaluation)指标[20]来对模型生成的商品精简标题进行评估, 该指标目前已被广泛地应用于DUC(Document Understanding Conference)摘要评测1.为了更全面地衡量所生成商品短标题的质量, 同文献[3]一样, 本文也在ROUGE基础上引入了精确率(Precision)、召回率(Recall)及F1分数(F1-score)来进一步分析模型性能.联合评估计算的公式分别为

| $\begin{align} &\label{eq11} {\rm ROUGE}\_P=\frac{\vert S\cap S_h \vert }{\vert S\vert }, \end{align} $ | (11) |

| $\begin{align} &\label{eq12} {\rm ROUGE}\_R=\frac{\vert S\cap S_h \vert }{\vert S_h \vert }, \end{align} $ | (12) |

| $\begin{align} &\label{eq13}{\rm ROUGE}\_{\rm F}1 =2\times \frac{ {\rm ROUGE}\_P\times {\rm ROUGE}\_R}{{\rm ROUGE}\_P+{\rm ROUGE}\_R}, \end{align} $ | (13) |

其中,

本文分别在长文本商品标记数据集LESD4EC_L和短文本商品标记数据集LESD4EC_S上对ERS-NET模型及其他基准模型进行了测试验证, 实验结果如表 2所示.

| 表 2 在不同数据集上的商品名称精简实验结果 Tab. 2 Results on different datasets |

从表 2中可以看出, 在商品名称精简即商品短标题生成中, Seq2Seq模型明显逊色于其他模型.相比于其他基准模型, Seq2Seq模型由编码和解码两部分组成, 两段式的数据交互不可避免地会引起信息损失, 尽管在实验的过程中, 使用了Luong注意力[10]来对Seq2Seq模型增强, 依然无法改善该模型的ROUGE_F1. FE-NET模型作为专有的商品短标题生成模型, 依托于丰富的外部商品特征信息, 在实验中取得了较好的成绩. Self-ATT可以很好地捕捉句子的全局依赖特性, 在冗余商品名称精简中, 分别在LESD4EC_L数据集和LESD4EC_S数据集上取得了ROUGE_F1为73.73%和80.65%.本文在此基础上, 使用小规模GRU网络对其进行语义时序增强, 最终得到的ERS-NET模型, 相对于FE-NET模型, 它弱化了模型对全局特征的依赖, 仅仅考虑了数据本身的属性特征, 其ROUGE_P、ROUGE_R、ROUGE_F1在不同数据集上均取得了最优, ROUGE_F1分别取得了1.63个百分点和1.37个百分点的提升.

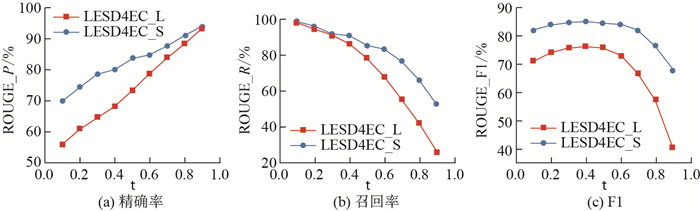

为了进一步调整ERS-NET模型对商品名称的精简能力, 本文使用Sigmoid激活层取代了原有的Softmax分类层, 通过调节分类阈值

在商品名称精简中, 虽然本文使用了较小规模的基于RNN结构的GRU网络对自注意力机制网络进行时序增强, 但依然要防止较高复杂度的GRU网络产生的额外计算开销, 故需要对GRU的计算维度

| 表 3 不同GPU下每万条数据执行时间 Tab. 3 Computational time per ten thousand data items on GPU |

1https://www.nvidia.cn/content/dam/en-zz/Solutions/design-visualization/documents/Quadro-P600

2https://www.nvidia.cn/geforce/products/10series/geforce-gtx-1060/

|

图 3 不同阈值下商品名称精简任务的精确率、召回率、F1变化情况 Fig.3 ROUGE performance on product title compression with different thresholds |

本文选取同时出现在两个数据集中的两个商品, 通过具体案例进一步分析ERS-NET模型在商品名称精简上的优越性.如表 4所示, 其中后缀L和S分别代表在数据集LESD4EC_L和LESD4EC_S上进行的实验, LESD4EC_S数据集在标签长度上做了上限为3的约束.可以看出, 案例1中, 模型通过在不同数据集上进行学习, 可以很好地根据各自数据集的标签特性对原商品名称进行精简.若以案例中的标签为评判基准, ERS-NET模型在案例2上的预测结果逊色于案例1;但从精简的结果来看, 在LESD4EC_L数据集上, 其预测的商品精简标题"捷波朗运动心率无线蓝牙防水耳机"并没有影响大众对商品的理解, 并且在LESD4EC_S上的预测结果"jabra 蓝牙耳机"要比原标签"jabra 捷波朗耳机"具有更好的可读性.从具体的实验案例可以看出, 在真实的应用场景下, ERS-NET模型依然具有良好的商品名称精简能力.

| 表 4 两个真实应用场景下的冗余商品名称精简案例 Tab. 4 Case study with real application scenarios |

冗长商品名称精简旨在精炼商品命名信息, 为构建跨平台商品知识体系、多源商品数据融合提供必要的数据支持.本文在商品数据集LESD4EC的基础上构造了商品精简标记数据集LESD4EC_L和LESD4EC_S, 并在此基础上针对商品名称精简进行了实验分析, 提出了基于自注意力机制商品名称精简模型ERS-NET, 该模型使用较小规模的GRU神经单元对商品名称进行语义时序增加.实验结果表明, 本文提出的ERS-NET模型在两种规格的商品名称精简中相对于已提出的商品名称精简模型均取得了最优.在之后的工作中, 会以本文提出的ERS-NET模型为基础, 继续研究在多源商品数据情况下商品实体的解析.

| [1] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]//Advances in neural information processing systems. 2017: 5998-6008.

|

| [2] |

GONG Y, LUO X S, ZHU K Q, et al. Automatic generation of chinese short product titles for mobile display[J]. arXiv preprint arXiv: 1803.11359, 2018.

|

| [3] |

LIU Z Y, HUANG W Y, ZHENG Y B, et al. Automatic keyphrase extraction via topic decomposition[C]//Proceedings of the 2010 conference on empirical methods in natural language processing. Association for Computational Linguistics, 2010: 366-376.

|

| [4] |

ROSE S, ENGEL D, CRAMER N, et al. Automatic keyword extraction from individual documents[M]//Text mining: Applications and theory. Hoboken: A John Wiley and Sons, Ltd., 2010: 1-20.

|

| [5] |

MIHALCEA R, TARAU P. Textrank: Bringing order into text[C]//Proceedings of the 2004 conference on empirical methods in natural language processing. 2004.

|

| [6] |

ZHAO W X, JIANG J, HE J, et al. Topical keyphrase extraction from Twitter[C]//Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics. Association for Computational Linguistics, 2011: 379-388.

|

| [7] |

HOCHREITER S, SCHMIDHUBER J. Long short-term memory[J]. Neural Computation, 1997, 9(8): 1735-1780. DOI:10.1162/neco.1997.9.8.1735 |

| [8] |

CHO K, VAN MERRIENBOER B, GULCEHRE C, et al. Learning phrase representations using RNN encoder-decoder for statistical machine translation[C]//Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP). 2014: 1724-1734.

|

| [9] |

BAHDANAU D, CHO K, BENGIO Y. Neural machine translation by jointly learning to align and translate[J]. arXiv preprint arXiv: 1409.0473, 2014.

|

| [10] |

LUONG T, PHAM H, MANNING C D. Effective approaches to attention-based neural machine translation[C]//Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing. 2015: 1412-1421.

|

| [11] |

SUTSKEVER I, VINYALS O, LE Q V. Sequence to sequence learning with neural networks[C]//Advances in Neural Information Processing Systems. 2014: 3104-3112.

|

| [12] |

NALLAPATI R, ZHOU B W, DOS SANTOS C, et al. Abstractive text summarization using sequence-to-sequence RNNs and beyond[C]//Proceedings of The 20th SIGNLL Conference on Computational Natural Language Learning. 2016: 280-290.

|

| [13] |

NALLAPATI R, ZHAI F F, ZHOU B W. Summarunner: A recurrent neural network based sequence model for extractive summarization of documents[C]//Proceedings of the 31st AAAI Conference on Artificial Intelligence (AAAI-17). 2017: 3075-3081.

|

| [14] |

SEE A, LIU P J, MANNING C D. Get to the point: Summarization with pointer-generator networks[C]//Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). 2017: 1073-1083.

|

| [15] |

VINYALS O, FORTUNATO M, JAITLY N. Pointer networks[C]//Advances in Neural Information Processing Systems 28(NIPS 2015). 2015: 2692-2700.

|

| [16] |

GOODFELLOW I, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]//Advances in Neural Information Processing Systems 27(NIPS 2014). 2014: 2672-2680.

|

| [17] |

ZHANG J, ZOU P, LI Z, et al. Multi-modal generative adversarial network for short product title generation in mobile e-commerce[C]//Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 2(Industry Papers). 2019: 64-72.

|

| [18] |

WANG J G, TIAN J F, QIU L, et al. A multi-task learning approach for improving product title compression with user search log data[C]//32nd AAAI Conference on Artificial Intelligence. 2018: 451-458.

|

| [19] |

KINGMA D P, BA J. Adam: A method for stochastic optimization[J]. arXiv preprint arXiv: 1412.6980, 2014.

|

| [20] |

LIN C Y, HOVY E. Automatic evaluation of summaries using n-gram co-occurrence statistics[C]//Proceedings of the 2003 Human Language Technology Conference of the North American Chapter of the Association for Computational Linguistics. 2003: 150-157.

|